D2

Администратор

- Регистрация

- 19 Фев 2025

- Сообщения

- 4,380

- Реакции

- 0

Автор besenok

Статья написана для Конкурса статей #10

Всем привет, сегодня я хочу рассказать как я написал не большую программу, которая тестирует веб ресурсы на различные векторы атак, а так же собирает разного рода информацию о веб ресурсах.

Одна из необычных функций, это сбор со всего интернета сайтов по нашим ключевым словам( подходящей под эти слова тематикой) для проведения дальнейших атак. Брутфорс собранных таргетов, сбор почт, ддос, эксплоит пак, веб сканер, и готовые фишинговые письма. Но к этому мы вернемся чуть позже)

Весь код писан на java. Данная статья скорее больше походит не как туториал для новичков, а как рассказ о своем опыте написания подобных программ, и подробное описание что данная программа может делать. Основной идеей создания данного проекта было - держать все нужные скрипты и утилиты для работы в одном месте, имея разный спектр задач, и что бы программа служила своеобразным мультитулом.

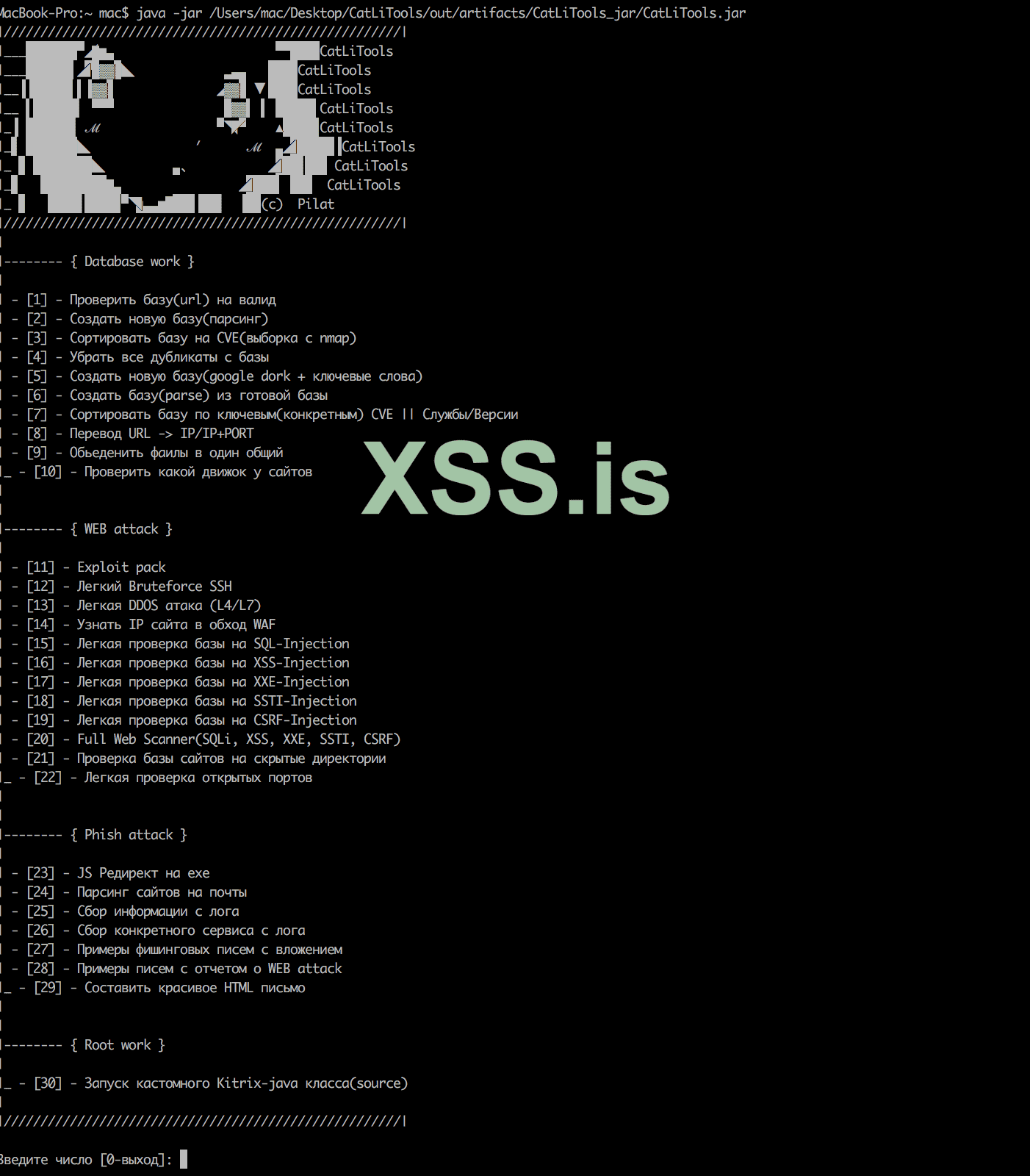

Начнем с небольшого обзора что умеет данная программа:

Есть 3 вида утилит: Database work, WEB attack, Phish attack

- Проверить базу(url) на валид

Тут все просто, передаем на вход список сайтов(site.com), и програма возвращает список сайтов которые возвращают код ответа 200, и где не стоит фаервол.

- Создать новую базу(парсинг)

- Создать новую базу(google dork + ключевые слова)

Тут мы будем парсить url сайтов, по нашим ключевым словам. На этом пункте остановимся по подробнее, я на скринах покажу что куда тыкать, и все остальные функции работают по аналогии. Отвечу сразу на вопрос, зачем если есть шодан, который сразу дает сайты с открытыми портами, службами и их версиями - шодан выдает уязвимые сервисы, но не определенно только сайты, можно конечно же указать в параметр поиска что бы был открыт порт 8080/80, но тематику таких сайтов указать к сожалению не получиться. Наша же программа с начало ищет подходящие сайты, и уже потом массово проверяет их на все возможные уязвимости.

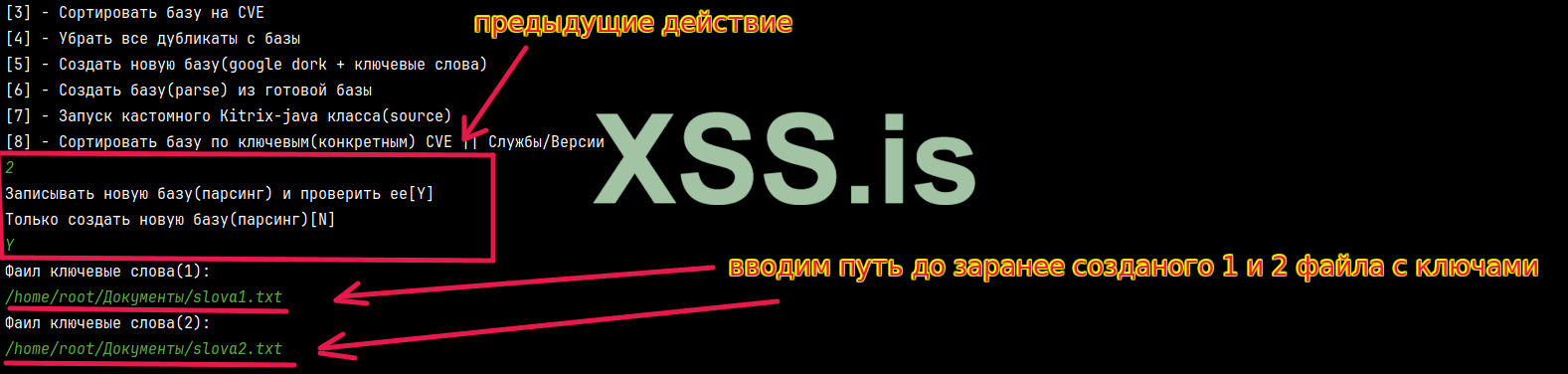

Допустим нас интересуют сайты на тематику покупки игровых аккаунтов или же аккаунтов соц сетей. Для этого мы создаем 2 файла: в певром мы добавим ключевые слова такие как купить, приобрести, шоп, маркет и тд. А во втором мы добавим такие слова как телеграм, инстаграм, твитер, кс2, валорант и тд. Обратите внимание, что для примера я написал ключевые слова для поиска русскими буквами, для реального поиска они должны быть английскими(отсеить ру), а так же при старте парсинга рекомендуется добавить прокси(через настройки сети или проксифаер) или перекинуть весь трафик через тор. это улучшит поисковую выдачу и отсеит ру и снг!

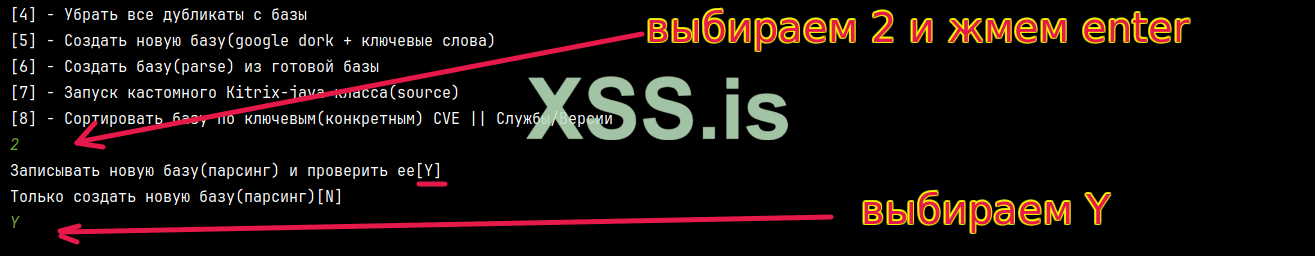

Сам алгоритм создания базы ключей из 2 баз слов выглядит так(для примера на тематике крипты привел пример):

Так же мы говорим хотим ли мы создать только базу ключей, или же сразу пройтись по ней и создать базу сайтов:

Потом вводим пути до наших файлов с ключевыми словами:

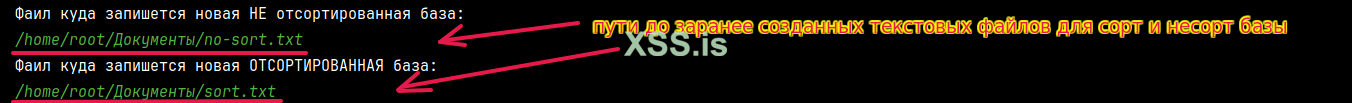

И путь куда запишется отсортированная и не отсортированная база:

При создании базы ключей, мы можем воспользоваться встроенной функцией добавления гугл дорков, допустим указать что нам нужны все вордпрес сайты, в которых есть на главной странице наши ключевые слова. И таким итогом у нас получиться база шопов на ворд пресс, заточенных на аккаунтах соц сетей и аккаунтов игр.

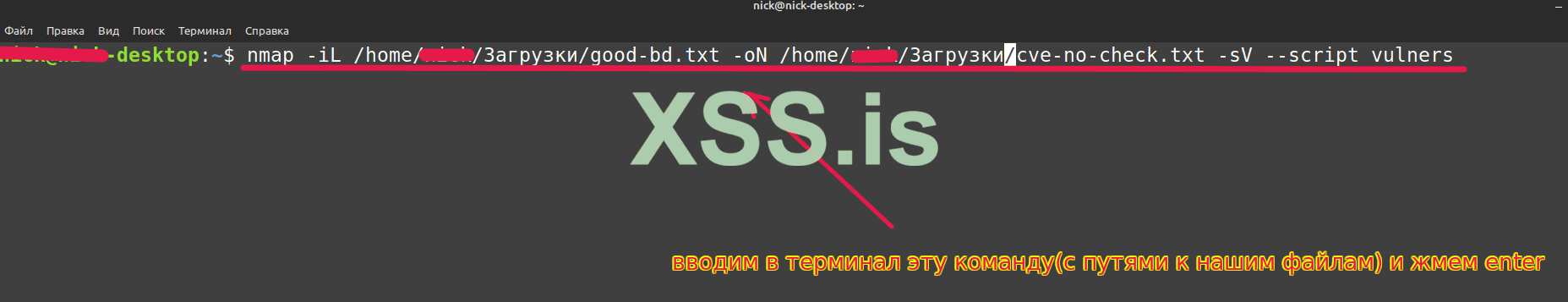

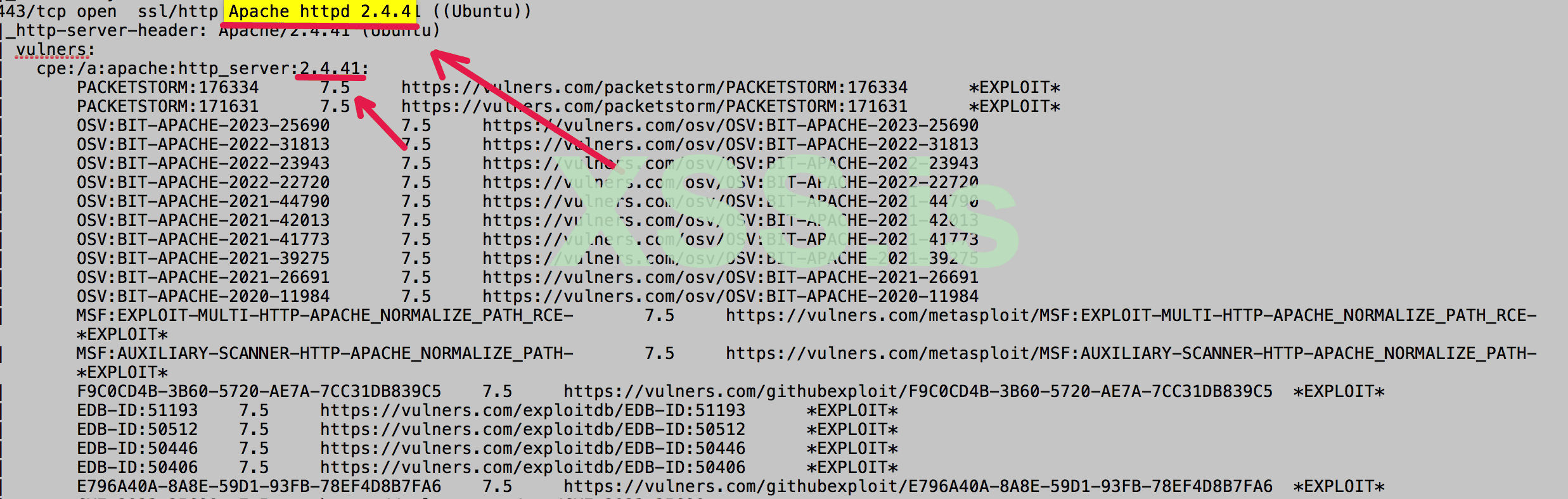

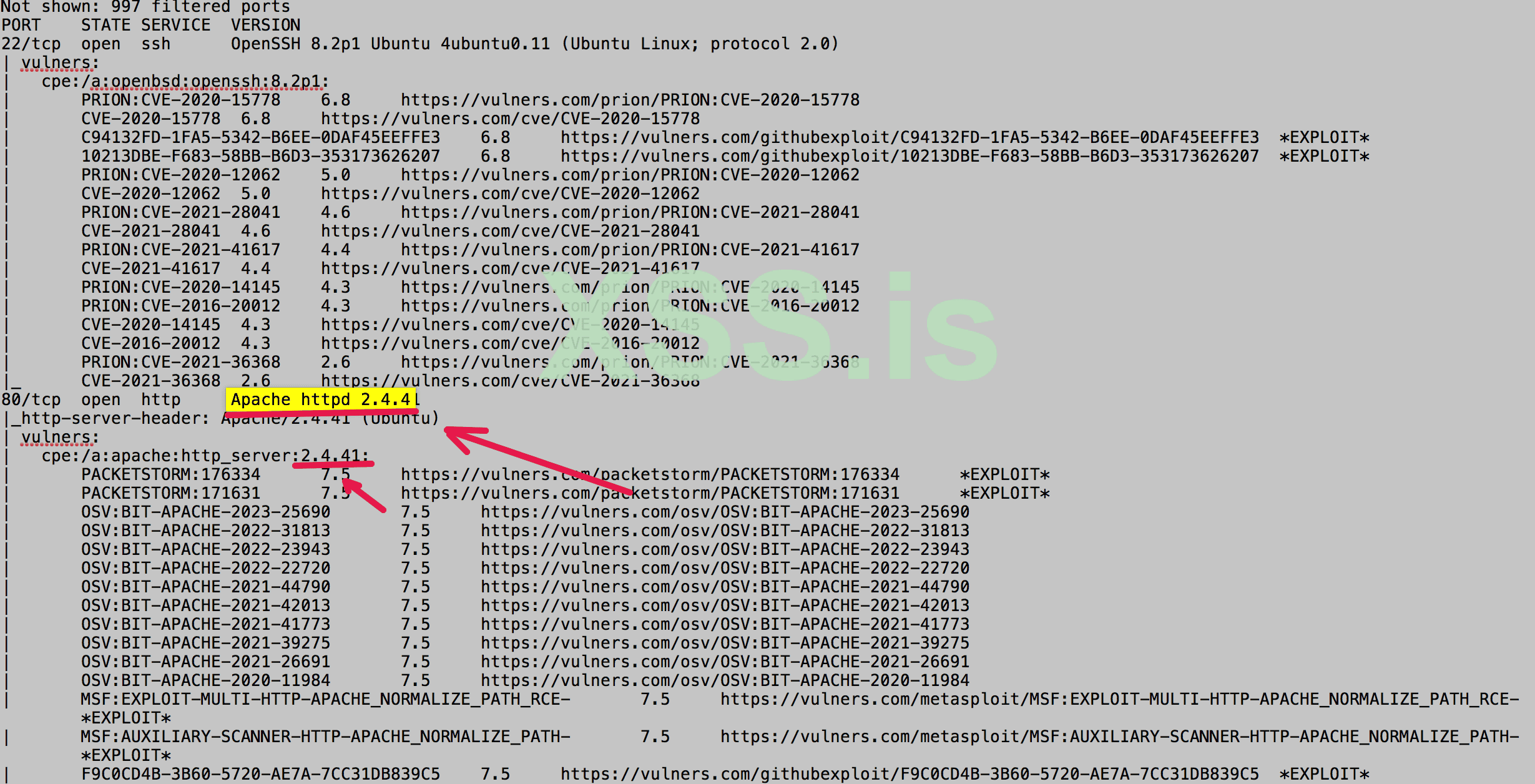

После сбора таргетов, мы можем закинуть их в nmap с плагином vulners - так просто удобнее, к списку портов, сервисов и их версий, добавляются еще и списки эксплойтов которые эксплотируют ту или иную уязвимость.

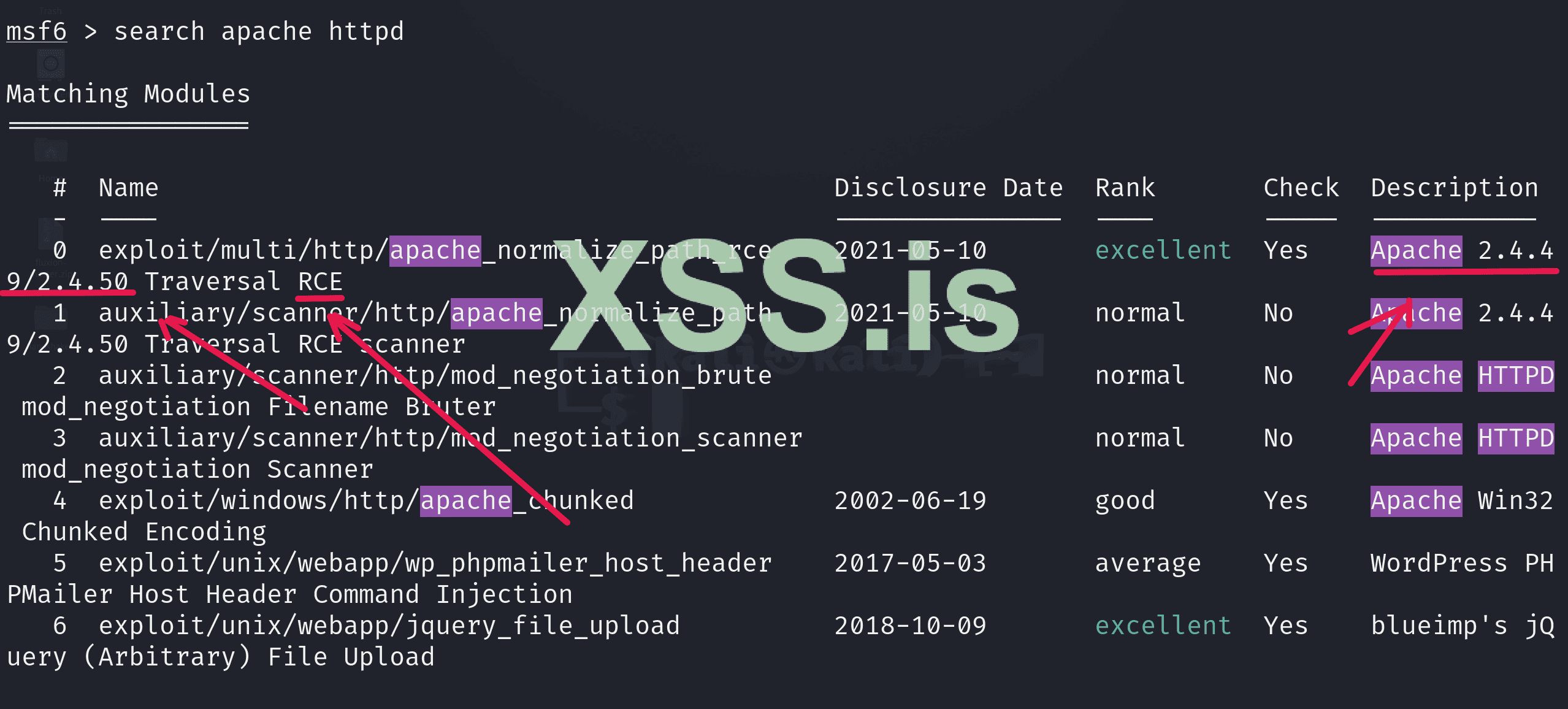

Далее можно по метасплойту найти подходящий экслоит, и пробовать раскрутить уязвимость:

Или sqlmap для дальнейшей проверки на sql иньекцию:

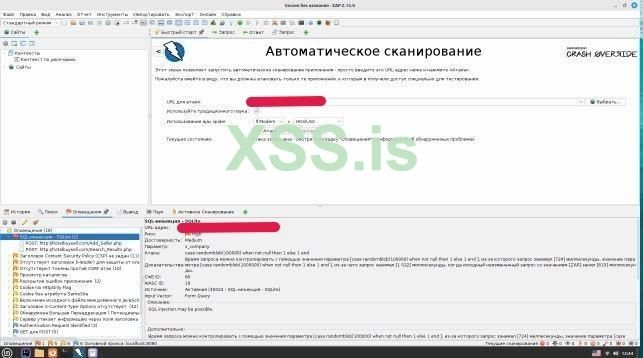

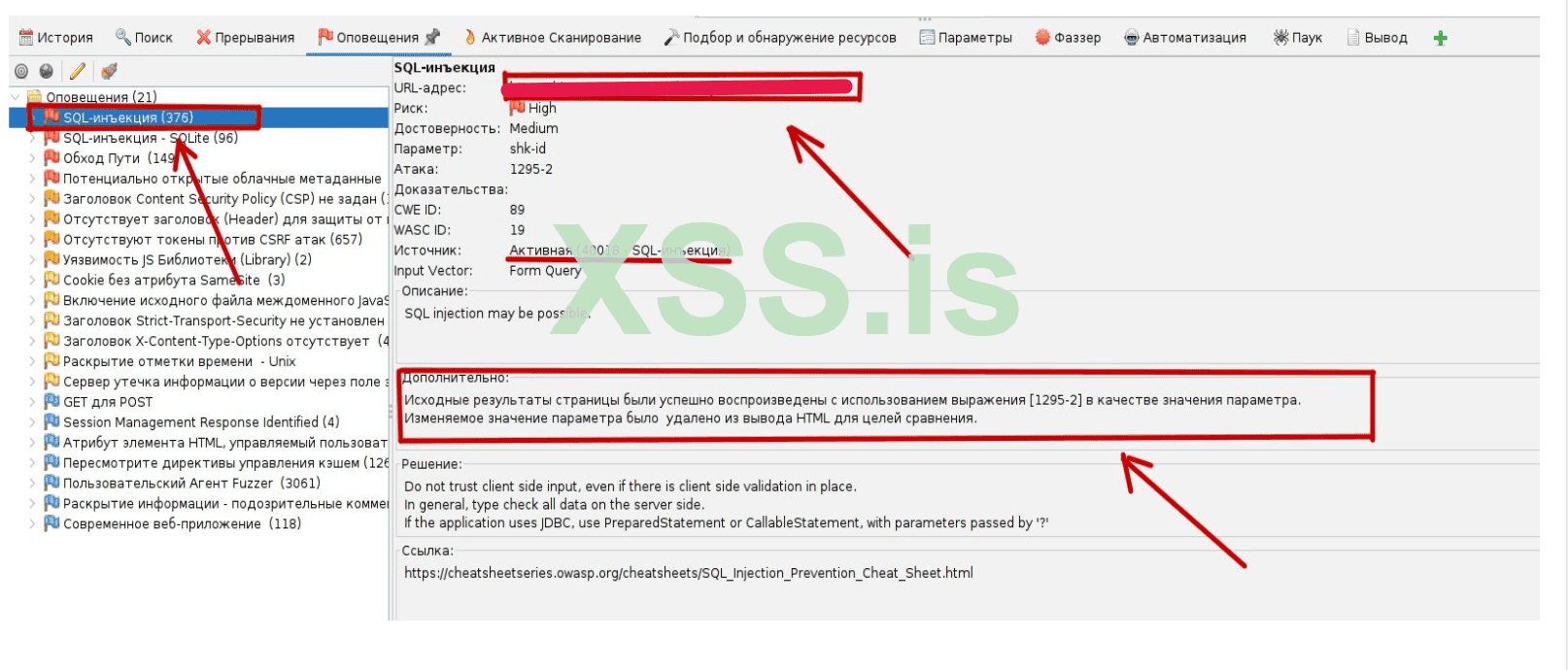

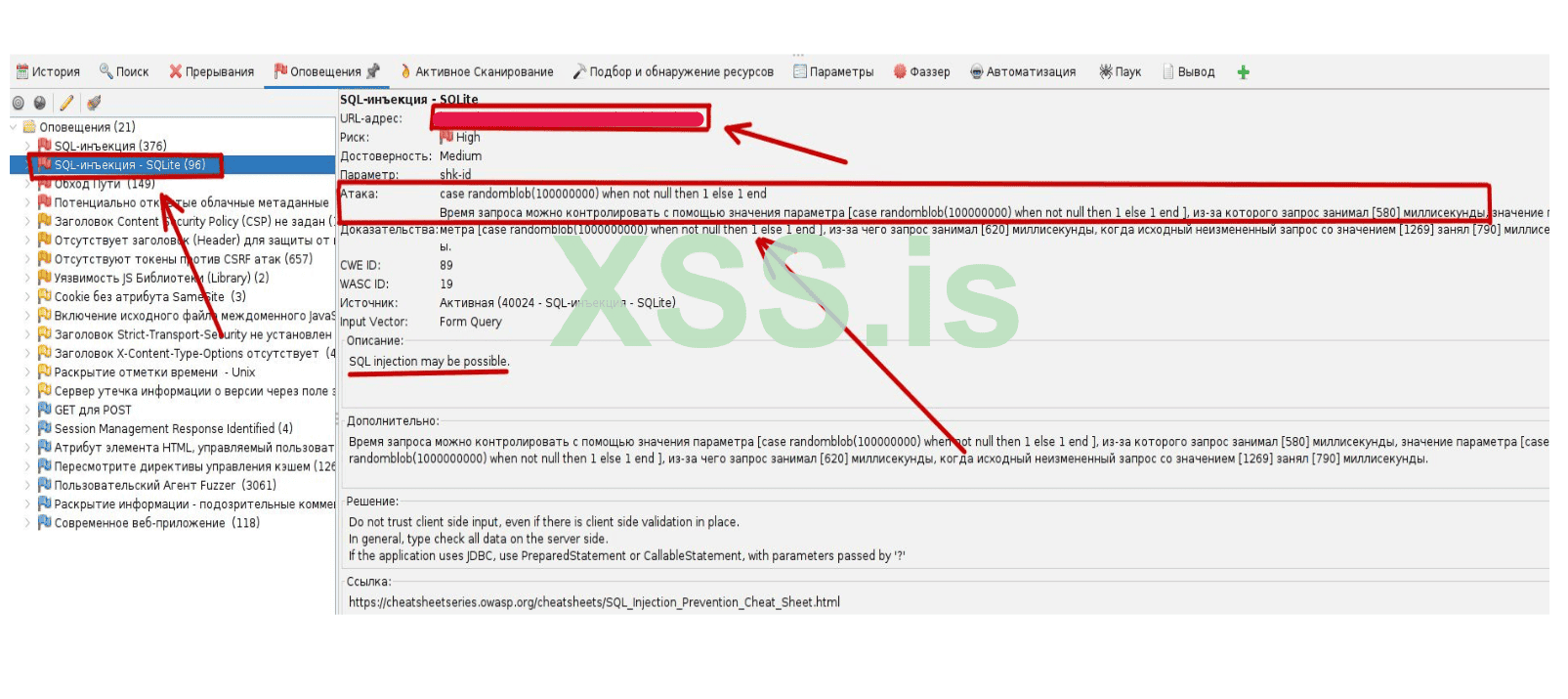

Но я еще проверял особо интересные сайты с помощью zap:

Вот пример как выглядят доступ после поного цикла сканирований и работы с найдеными уязвимостями - админка сайта генератора прокси. Он использовал api royal для генерации резедентных проски, которые можно было генерировать по гео, протоколу и таймингу работы:

- Сортировать базу на CVE(выборка с nmap)

CVE (Common Vulnerabilities and Exposures) – база данных общеизвестных уязвимостей программного обеспечения, каждая запись которой имеет уникальный идентификатор.

Как только мы получили базу с url сайтов, у нас все готово для дальнейшей передачи в nmap со скриптом vulners для анализа открытых портов и запущенных служб и их версий на известные уязвимости, с последующей выдачей отчетов. Рекомендую отобрать валидные сайты заранее с помощью скрипта о котором говорил вышел. Дело в том, что мы парсим html ответ от duckduckgo, который содержит url сайтов, если сайт не доступен или на нем стоит фаервол, анализ с nmap может проходить дольше чем обычно, по этому рекомендуется отсеить мусорные сайты заранее что бы nmap не тратил на них время.

Для начала работы в данном направлении, нам стоит подробно ознакомиться с документацие nmap, благо это можно сделать на официальном сайте - nmap.org. Так же нам нужно Скачать

Статья написана для Конкурса статей #10

Всем привет, сегодня я хочу рассказать как я написал не большую программу, которая тестирует веб ресурсы на различные векторы атак, а так же собирает разного рода информацию о веб ресурсах.

Одна из необычных функций, это сбор со всего интернета сайтов по нашим ключевым словам( подходящей под эти слова тематикой) для проведения дальнейших атак. Брутфорс собранных таргетов, сбор почт, ддос, эксплоит пак, веб сканер, и готовые фишинговые письма. Но к этому мы вернемся чуть позже)

Весь код писан на java. Данная статья скорее больше походит не как туториал для новичков, а как рассказ о своем опыте написания подобных программ, и подробное описание что данная программа может делать. Основной идеей создания данного проекта было - держать все нужные скрипты и утилиты для работы в одном месте, имея разный спектр задач, и что бы программа служила своеобразным мультитулом.

Начнем с небольшого обзора что умеет данная программа:

Есть 3 вида утилит: Database work, WEB attack, Phish attack

- Проверить базу(url) на валид

Тут все просто, передаем на вход список сайтов(site.com), и програма возвращает список сайтов которые возвращают код ответа 200, и где не стоит фаервол.

- Создать новую базу(парсинг)

- Создать новую базу(google dork + ключевые слова)

Тут мы будем парсить url сайтов, по нашим ключевым словам. На этом пункте остановимся по подробнее, я на скринах покажу что куда тыкать, и все остальные функции работают по аналогии. Отвечу сразу на вопрос, зачем если есть шодан, который сразу дает сайты с открытыми портами, службами и их версиями - шодан выдает уязвимые сервисы, но не определенно только сайты, можно конечно же указать в параметр поиска что бы был открыт порт 8080/80, но тематику таких сайтов указать к сожалению не получиться. Наша же программа с начало ищет подходящие сайты, и уже потом массово проверяет их на все возможные уязвимости.

Допустим нас интересуют сайты на тематику покупки игровых аккаунтов или же аккаунтов соц сетей. Для этого мы создаем 2 файла: в певром мы добавим ключевые слова такие как купить, приобрести, шоп, маркет и тд. А во втором мы добавим такие слова как телеграм, инстаграм, твитер, кс2, валорант и тд. Обратите внимание, что для примера я написал ключевые слова для поиска русскими буквами, для реального поиска они должны быть английскими(отсеить ру), а так же при старте парсинга рекомендуется добавить прокси(через настройки сети или проксифаер) или перекинуть весь трафик через тор. это улучшит поисковую выдачу и отсеит ру и снг!

Сам алгоритм создания базы ключей из 2 баз слов выглядит так(для примера на тематике крипты привел пример):

Так же мы говорим хотим ли мы создать только базу ключей, или же сразу пройтись по ней и создать базу сайтов:

Потом вводим пути до наших файлов с ключевыми словами:

И путь куда запишется отсортированная и не отсортированная база:

При создании базы ключей, мы можем воспользоваться встроенной функцией добавления гугл дорков, допустим указать что нам нужны все вордпрес сайты, в которых есть на главной странице наши ключевые слова. И таким итогом у нас получиться база шопов на ворд пресс, заточенных на аккаунтах соц сетей и аккаунтов игр.

После сбора таргетов, мы можем закинуть их в nmap с плагином vulners - так просто удобнее, к списку портов, сервисов и их версий, добавляются еще и списки эксплойтов которые эксплотируют ту или иную уязвимость.

Далее можно по метасплойту найти подходящий экслоит, и пробовать раскрутить уязвимость:

Или sqlmap для дальнейшей проверки на sql иньекцию:

Но я еще проверял особо интересные сайты с помощью zap:

Вот пример как выглядят доступ после поного цикла сканирований и работы с найдеными уязвимостями - админка сайта генератора прокси. Он использовал api royal для генерации резедентных проски, которые можно было генерировать по гео, протоколу и таймингу работы:

- Сортировать базу на CVE(выборка с nmap)

CVE (Common Vulnerabilities and Exposures) – база данных общеизвестных уязвимостей программного обеспечения, каждая запись которой имеет уникальный идентификатор.

Как только мы получили базу с url сайтов, у нас все готово для дальнейшей передачи в nmap со скриптом vulners для анализа открытых портов и запущенных служб и их версий на известные уязвимости, с последующей выдачей отчетов. Рекомендую отобрать валидные сайты заранее с помощью скрипта о котором говорил вышел. Дело в том, что мы парсим html ответ от duckduckgo, который содержит url сайтов, если сайт не доступен или на нем стоит фаервол, анализ с nmap может проходить дольше чем обычно, по этому рекомендуется отсеить мусорные сайты заранее что бы nmap не тратил на них время.

Для начала работы в данном направлении, нам стоит подробно ознакомиться с документацие nmap, благо это можно сделать на официальном сайте - nmap.org. Так же нам нужно Скачать

View hidden content is available for registered users!