D2

Администратор

- Регистрация

- 19 Фев 2025

- Сообщения

- 4,380

- Реакции

- 0

Автор student / мой_телеграмм_канал

Источник: https://xss.is

Саламалейкум! Уже подъехала шестая часть "Веб-хакинг мои попытки стать лучшим хакером в России". Уважаемый человек ice80 подогнал мне монету и я понял, что время выпускать новую часть. Рекомендую ознакомиться с моими прошлыми статьями ниже:

https://xss.is/threads/103347/ #1

https://xss.is/threads/104015/ #2

https://xss.is/threads/105220/ #3

https://xss.is/threads/105985/ #4

https://xss.is/threads/106229/ #5

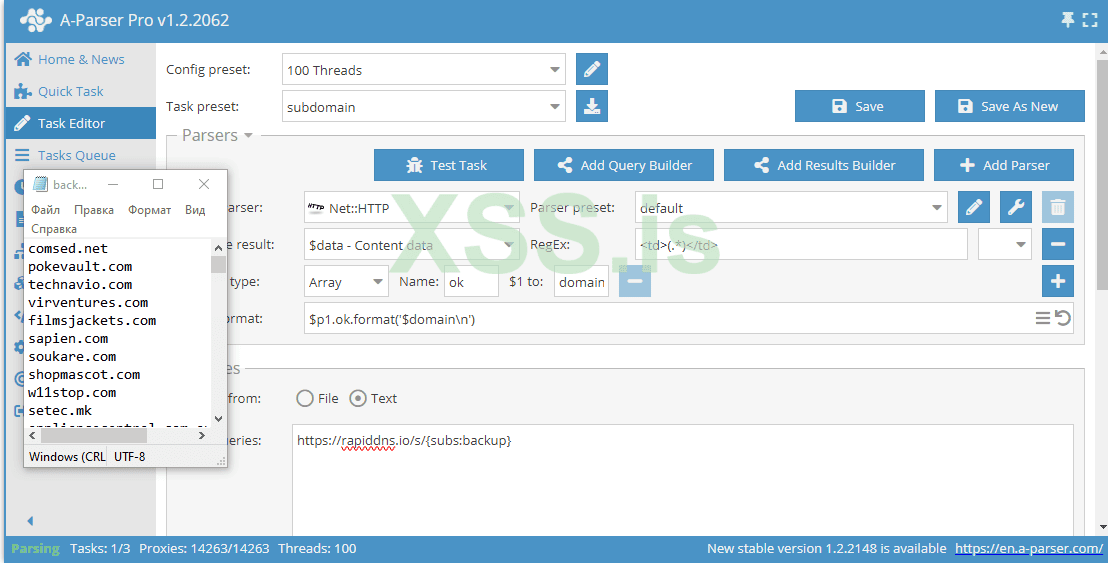

Продолжаю двигать тему с A-Parser вперед. Я еще написал не обо всем что хотел. Недавно на другом форуме мне прилетел заказа спарсить все сайты с OpenCart и найти админки. Парсить сайты особо не пришлось, потому что на форуме лежит тема со всеми сайтами за январь, оставалось только их проверить на валид и поискать админки. Понятное дело, что сначала я пробежался по дефолту пути /admin и выявил много админок, но они в основном были старых версий 1.x. Потому что на новых уже требовали поменять дефолт путь. Заказчик предложил спарсить все сабдомены и искать там. Когда у тебя на руках сотни тысяч сайтов, а тебе нужно получить все известные поддомены, то брутить их вообще не вариант. Если вы читали мою первую статью #1, то я там давал сайты с которых можно собрать поддомены. Так вот я просто решил спарсить с них поддомены.

Тут все просто на самом деле. Дефолтный парсер Net::HTTP, парсинг по разметке с помощью регулярного выражения <td>(.*)>/td> то есть у нас группа (.*) это любое содержимое тэга <td>. Она и будет выводиться в параметр $domain. А ok - это массив, потому что поддоменов может быть больше 1. Ну и указываем на вход https://rapiddns.io/s/{subs:backup}. \aparser\queries\subs тут создаем файл backup.txt и указываем его в subs без расширения. На выходе получаем поддомены. Если админ некорректно настроил редиректы, то мы можем узнать полный путь к админке. Например вот поддомен OpenCart:

https://oc.officensupplies.com если вы перейдете, то вас перебросит на https://www.officensupplies.com/shop/adm21/ так вы можете собрать админки, которые еще не задрочили.

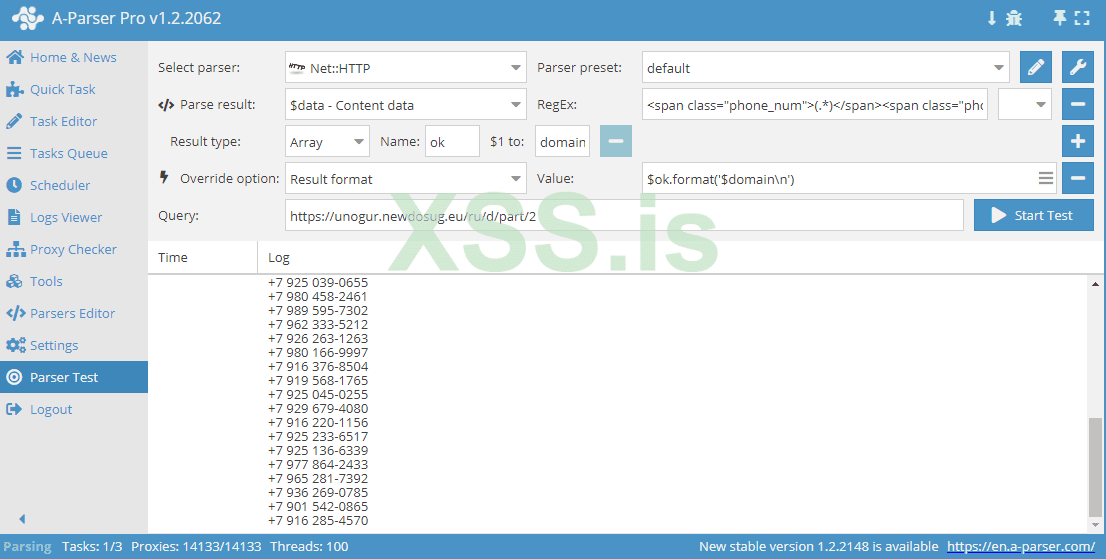

следующий заказ прилетел от STOP404. Я решил его выполнить бесплатно, написать статью. Суть в чем, он мне дал сайты с анкетами индивидуалок(проституток кто не в курсе) и задача состоит в том, чтобы спарсить номера. Начнем с самого легкого таргета https://unogur.newdosug.eu/ru/d/part/2 тут номера доступны всем и всего-лишь 1 страничка.

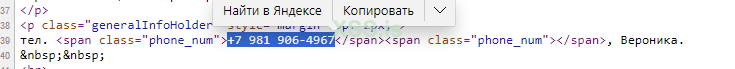

Меняем регулярного выражение и парсим номера. Составить regex очень легко. Копируем все, что между номером

а вместо номера ставим группу (.*) тип любое значение может быть и парсим. Easy dance Возьмем таргет покрупнее, потому что от предыдущих индивидуалок воняет блин гавном :d

Возьмем таргет покрупнее, потому что от предыдущих индивидуалок воняет блин гавном :d

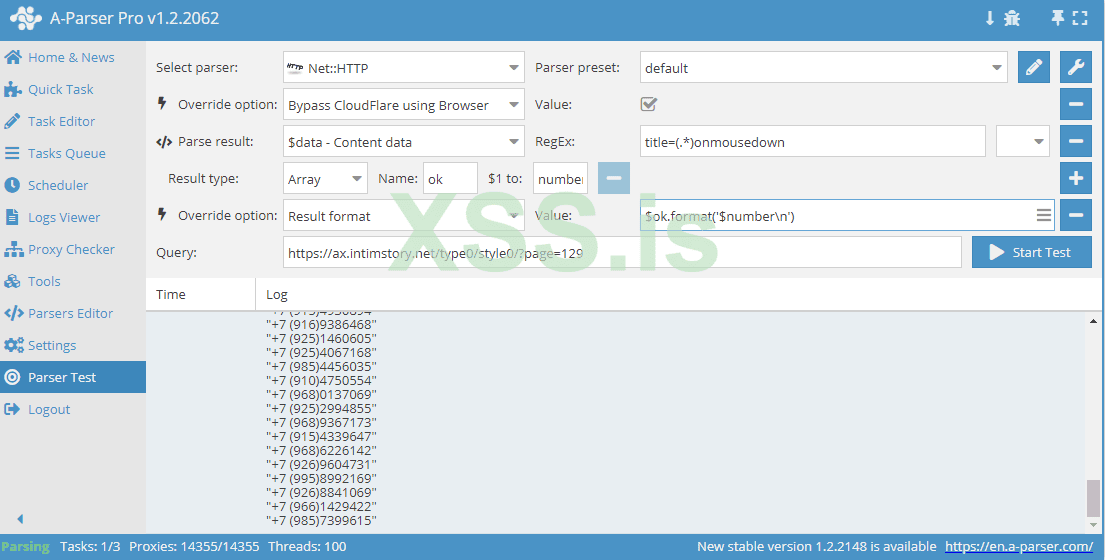

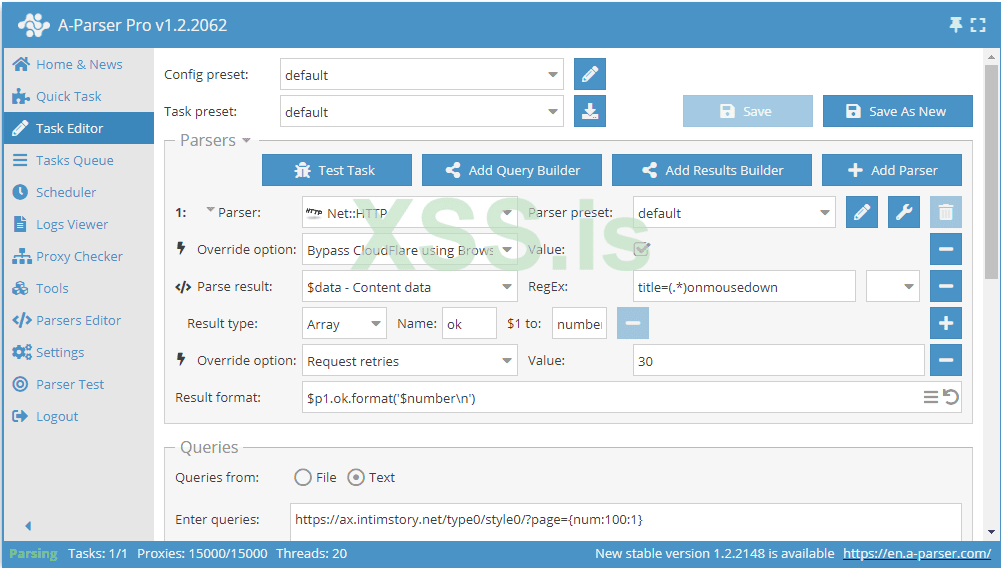

https://ax.intimstory.net меня заинтересовал этот. Потому что тут целых 129 страниц!!! Я долго не мог понять в чем дело, пока не отключил все опции и не увидел ответ от сервера 403 фобиден клаудфлайа Не надо забывать мы не на пайтоне, а на A-Parser. У нас есть опция bypass клауда. Врубаем ее и смотрим:

Не надо забывать мы не на пайтоне, а на A-Parser. У нас есть опция bypass клауда. Врубаем ее и смотрим:

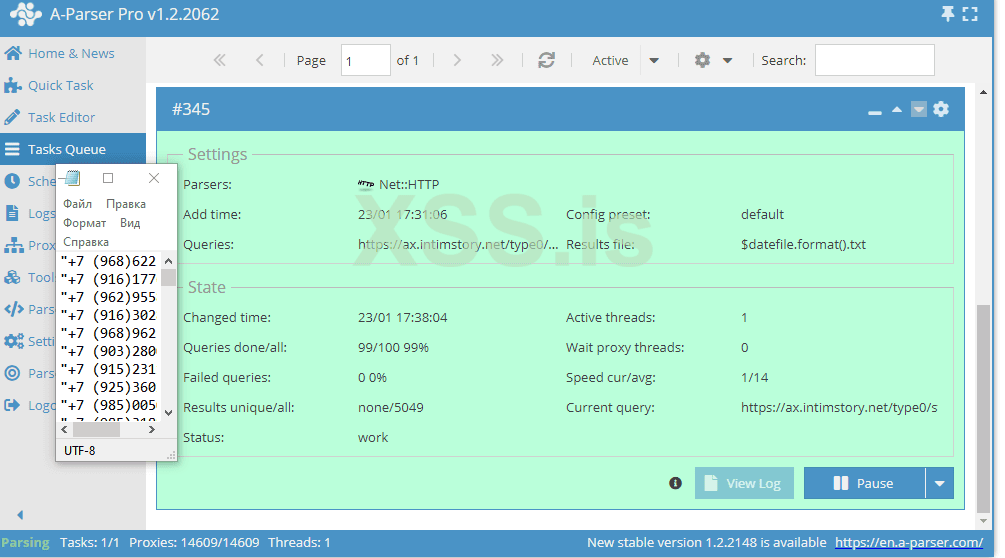

Теперь из тестового режима переходим в обычный и парсим. Используем макросы подстановок.

Я для теста выбрал от 100 к 1. Почему-то от 269 к 1 не работало...

Больше 2 тысяч номеров успешно спарсил. В подарок прикрепляю номера индивидуалок, так как товарищ просил, который таргеты прислал.

Теперь перейдем еще к одной интересной темке. На форуме часто спрашивают, где брать таргеты шоб наломать, база выкачать.

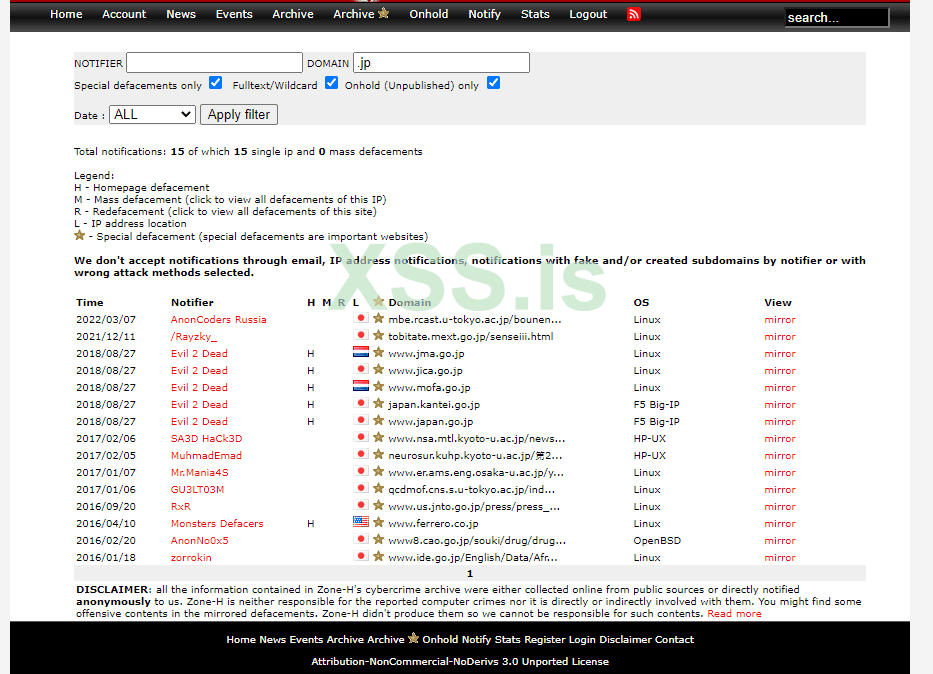

www.zone-h.org есть такой ресурс, где какеры выкладывают сайты, которые они наломали или нашли уязвимость. Там даже в корне многих сайтов лежат .txt или .html странички шо сайт взломан. Там много дырявых сайтов и я хочу их спарсить. Дальше вы можете их закинуть в Acunetix/Nuclei и найти скули.

Можно даже отфильтровать по домену. В данном случае Япония. Мы видим когда сайт был атакован, кем, домен, операционную систему и другую информацию. Таргет интересный, придется помучаться, т.к там необычная капча Если интересно и накидаете бомжу донатов, то сделаем bypass капчи на JS.

Если интересно и накидаете бомжу донатов, то сделаем bypass капчи на JS.

Источник: https://xss.is

Саламалейкум! Уже подъехала шестая часть "Веб-хакинг мои попытки стать лучшим хакером в России". Уважаемый человек ice80 подогнал мне монету и я понял, что время выпускать новую часть. Рекомендую ознакомиться с моими прошлыми статьями ниже:

https://xss.is/threads/103347/ #1

https://xss.is/threads/104015/ #2

https://xss.is/threads/105220/ #3

https://xss.is/threads/105985/ #4

https://xss.is/threads/106229/ #5

Продолжаю двигать тему с A-Parser вперед. Я еще написал не обо всем что хотел. Недавно на другом форуме мне прилетел заказа спарсить все сайты с OpenCart и найти админки. Парсить сайты особо не пришлось, потому что на форуме лежит тема со всеми сайтами за январь, оставалось только их проверить на валид и поискать админки. Понятное дело, что сначала я пробежался по дефолту пути /admin и выявил много админок, но они в основном были старых версий 1.x. Потому что на новых уже требовали поменять дефолт путь. Заказчик предложил спарсить все сабдомены и искать там. Когда у тебя на руках сотни тысяч сайтов, а тебе нужно получить все известные поддомены, то брутить их вообще не вариант. Если вы читали мою первую статью #1, то я там давал сайты с которых можно собрать поддомены. Так вот я просто решил спарсить с них поддомены.

Тут все просто на самом деле. Дефолтный парсер Net::HTTP, парсинг по разметке с помощью регулярного выражения <td>(.*)>/td> то есть у нас группа (.*) это любое содержимое тэга <td>. Она и будет выводиться в параметр $domain. А ok - это массив, потому что поддоменов может быть больше 1. Ну и указываем на вход https://rapiddns.io/s/{subs:backup}. \aparser\queries\subs тут создаем файл backup.txt и указываем его в subs без расширения. На выходе получаем поддомены. Если админ некорректно настроил редиректы, то мы можем узнать полный путь к админке. Например вот поддомен OpenCart:

https://oc.officensupplies.com если вы перейдете, то вас перебросит на https://www.officensupplies.com/shop/adm21/ так вы можете собрать админки, которые еще не задрочили.

следующий заказ прилетел от STOP404. Я решил его выполнить бесплатно, написать статью. Суть в чем, он мне дал сайты с анкетами индивидуалок(проституток кто не в курсе) и задача состоит в том, чтобы спарсить номера. Начнем с самого легкого таргета https://unogur.newdosug.eu/ru/d/part/2 тут номера доступны всем и всего-лишь 1 страничка.

Меняем регулярного выражение и парсим номера. Составить regex очень легко. Копируем все, что между номером

а вместо номера ставим группу (.*) тип любое значение может быть и парсим. Easy dance

https://ax.intimstory.net меня заинтересовал этот. Потому что тут целых 129 страниц!!! Я долго не мог понять в чем дело, пока не отключил все опции и не увидел ответ от сервера 403 фобиден клаудфлайа

Теперь из тестового режима переходим в обычный и парсим. Используем макросы подстановок.

Я для теста выбрал от 100 к 1. Почему-то от 269 к 1 не работало...

Больше 2 тысяч номеров успешно спарсил. В подарок прикрепляю номера индивидуалок, так как товарищ просил, который таргеты прислал.

Теперь перейдем еще к одной интересной темке. На форуме часто спрашивают, где брать таргеты шоб наломать, база выкачать.

www.zone-h.org есть такой ресурс, где какеры выкладывают сайты, которые они наломали или нашли уязвимость. Там даже в корне многих сайтов лежат .txt или .html странички шо сайт взломан. Там много дырявых сайтов и я хочу их спарсить. Дальше вы можете их закинуть в Acunetix/Nuclei и найти скули.

Можно даже отфильтровать по домену. В данном случае Япония. Мы видим когда сайт был атакован, кем, домен, операционную систему и другую информацию. Таргет интересный, придется помучаться, т.к там необычная капча